상품 정보

상품 기본설명

기본 개념부터 파이썬 기반의 최신 알고리즘 구현까지

상품 상세설명

프로젝트로 배우는 심층 강화학습의 이론과 실제!

이 책 《심층 강화학습 인 액션》은 환경이 제공하는 직접적인 피드백에 기반해서 환경에 적응하고 자신을 개선해 나가는 에이전트의 구현 방법을 설명한다. 흐름이 있는 하나의 강좌 형태로 구성된 이 책에서 여러분은 심층 강화학습의 기본 기법과 고급 기법을 미로 탈출이나 비디오 게임 플레이 같은 흥미로운 예제를 통해서 배우게 된다. 그 과정에서 심층 Q 신경망과 정책 기울기 방법을 포함한 여러 핵심 알고리즘을 익힐 수 있고, PyTorch와 OpenAI Gym 같은 업계 표준에 해당하는 라이브러리에도 익숙해질 것이다.

이 책 《심층 강화학습 인 액션》은 환경이 제공하는 직접적인 피드백에 기반해서 환경에 적응하고 자신을 개선해 나가는 에이전트의 구현 방법을 설명한다. 흐름이 있는 하나의 강좌 형태로 구성된 이 책에서 여러분은 심층 강화학습의 기본 기법과 고급 기법을 미로 탈출이나 비디오 게임 플레이 같은 흥미로운 예제를 통해서 배우게 된다. 그 과정에서 심층 Q 신경망과 정책 기울기 방법을 포함한 여러 핵심 알고리즘을 익힐 수 있고, PyTorch와 OpenAI Gym 같은 업계 표준에 해당하는 라이브러리에도 익숙해질 것이다.

목차

PART I 기초 1

CHAPTER 1 강화학습이란? 3

1.1 심층 강화학습에서 ‘심층’의 의미 4

1.2 강화학습 6

1.3 동적 계획법과 몬테카를로 방법 9

1.4 강화학습의 틀 12

1.5 강화학습으로 할 수 있는 일 16

1.6 왜 심층 강화학습인가? 18

1.7 이 책의 주요 설명 수단: 끈 그림 21

1.8 앞으로의 여정 22

요약 24

CHAPTER 2 강화학습 문제의 모형화: 마르코프 결정 과정 25

2.1 끈 그림과 이 책의 교육 방식 25

2.2 여러 팔 강도 문제의 해법 30

2.3 여러 팔 강도 문제를 광고 배치 최적화에 적용 41

2.4 PyTorch로 신경망 만들기 43

2.5 문맥적 강도 문제의 해법 47

2.6 마르코프 성질 52

2.7 향후 보상의 예측: 가치와 정책 함수 55

요약 59

CHAPTER 3 가장 나은 동작의 선택: 심층 Q 신경망(DQN) 61

3.1 Q 함수 62

3.2 Q 학습 개요 64

3.3 파국적 망각 방지: 경험 재현 85

3.4 목표망을 이용한 안정성 개선 92

3.5 정리 99

요약 102

CHAPTER 4 정책 기울기 방법 103

4.1 신경망을 이용한 정책 함수 구현 104

4.2 좋은 동작의 강화: 정책 기울기 알고리즘 108

4.3 OpenAI Gym 다루기 114

4.4 REINFORCE 알고리즘 117

요약 125

CHAPTER 5 좀 더 어려운 문제 풀기: 행위자-비평자 모형 127

5.1 가치 함수와 정책 함수의 결합 129

5.2 분산 훈련 135

5.3 이익 행위자-비평자 141

5.4 N-단계 행위자-비평자 151

요약 157

PART I I 더 높은 곳을 향하여 159

CHAPTER 6 또 다른 최적화 방법: 진화 알고리즘 161

6.1 강화학습의 또 다른 접근 방식 162

6.2 진화를 이용한 강화학습 163

6.3 CartPole을 위한 유전 알고리즘 172

6.4 진화 알고리즘의 장단점 180

6.5 규모가변적 대안으로서의 진화 알고리즘 182

6.5.6 기울기 기반 접근 방식의 규모 확장 189

요약 189

CHAPTER 7 모든 가능성의 탐색: 분포 심층 Q 신경망 191

7.1 기댓값 Q 학습의 문제점 192

7.2 다시 살펴보는 확률과 통계 197

7.3 벨먼 방정식 204

7.4 분포 Q 학습 206

7.5 확률분포의 비교 219

7.6 가상의 데이터에 대한 분포 DQN 225

7.7 분포 DQN을 이용한 아타리 프리웨이 학습 231

요약 237

CHAPTER 8 호기심 주도 탐험 239

8.1 예측 부호화를 이용한 희소 보상 문제 해결 241

8.2 역방향 동역학 예측 244

8.3 슈퍼 마리오브라더스 환경 설정 247

8.4 Q 신경망 전처리 250

8.5 Q 신경망과 정책 함수 설정 253

8.6 ICM(내재적 호기심 모듈) 257

8.7 그 밖의 내재적 보상 메커니즘들 271

요약 274

CHAPTER 9 다중 에이전트 강화학습 277

9.1 단일 에이전트에서 다중 에이전트로 278

9.2 이웃 Q 학습 282

9.3 1차원 이징 모형 286

9.4 평균장 Q 학습과 2차원 이징 모형 298

9.5 혼합 협조-경쟁 게임 309

요약 323

CHAPTER 10 해석 가능한 강화학습: 주의 모형과 관계 모형 325

10.1 주의와 관계 편향을 이용한 기계학습 해석성 개선 326

10.2 주의 메커니즘을 이용한 관계 추론 330

10.3 MNIST 이미지 분류를 위한 자가 주의 모형 구현 342

10.4 다중 헤드 주의 모형과 관계 DQN 356

10.5 이중 Q 학습 365

10.6 훈련과 주의 시각화 367

요약 376

CHAPTER 11 결론: 돌아보기와 내다보기 379

11.1 핵심 정리 380

11.2 심층 강화학습 분야의 미개척 주제들 382

11.3 마치며 386

APPENDIX A 수학, 심층학습, PyTorch 387

A.1 선형대수 388

A.2 미적분 390

A.3 심층학습 396A.4 PyTorch 397

참고문헌 402

찾아보기 406

CHAPTER 1 강화학습이란? 3

1.1 심층 강화학습에서 ‘심층’의 의미 4

1.2 강화학습 6

1.3 동적 계획법과 몬테카를로 방법 9

1.4 강화학습의 틀 12

1.5 강화학습으로 할 수 있는 일 16

1.6 왜 심층 강화학습인가? 18

1.7 이 책의 주요 설명 수단: 끈 그림 21

1.8 앞으로의 여정 22

요약 24

CHAPTER 2 강화학습 문제의 모형화: 마르코프 결정 과정 25

2.1 끈 그림과 이 책의 교육 방식 25

2.2 여러 팔 강도 문제의 해법 30

2.3 여러 팔 강도 문제를 광고 배치 최적화에 적용 41

2.4 PyTorch로 신경망 만들기 43

2.5 문맥적 강도 문제의 해법 47

2.6 마르코프 성질 52

2.7 향후 보상의 예측: 가치와 정책 함수 55

요약 59

CHAPTER 3 가장 나은 동작의 선택: 심층 Q 신경망(DQN) 61

3.1 Q 함수 62

3.2 Q 학습 개요 64

3.3 파국적 망각 방지: 경험 재현 85

3.4 목표망을 이용한 안정성 개선 92

3.5 정리 99

요약 102

CHAPTER 4 정책 기울기 방법 103

4.1 신경망을 이용한 정책 함수 구현 104

4.2 좋은 동작의 강화: 정책 기울기 알고리즘 108

4.3 OpenAI Gym 다루기 114

4.4 REINFORCE 알고리즘 117

요약 125

CHAPTER 5 좀 더 어려운 문제 풀기: 행위자-비평자 모형 127

5.1 가치 함수와 정책 함수의 결합 129

5.2 분산 훈련 135

5.3 이익 행위자-비평자 141

5.4 N-단계 행위자-비평자 151

요약 157

PART I I 더 높은 곳을 향하여 159

CHAPTER 6 또 다른 최적화 방법: 진화 알고리즘 161

6.1 강화학습의 또 다른 접근 방식 162

6.2 진화를 이용한 강화학습 163

6.3 CartPole을 위한 유전 알고리즘 172

6.4 진화 알고리즘의 장단점 180

6.5 규모가변적 대안으로서의 진화 알고리즘 182

6.5.6 기울기 기반 접근 방식의 규모 확장 189

요약 189

CHAPTER 7 모든 가능성의 탐색: 분포 심층 Q 신경망 191

7.1 기댓값 Q 학습의 문제점 192

7.2 다시 살펴보는 확률과 통계 197

7.3 벨먼 방정식 204

7.4 분포 Q 학습 206

7.5 확률분포의 비교 219

7.6 가상의 데이터에 대한 분포 DQN 225

7.7 분포 DQN을 이용한 아타리 프리웨이 학습 231

요약 237

CHAPTER 8 호기심 주도 탐험 239

8.1 예측 부호화를 이용한 희소 보상 문제 해결 241

8.2 역방향 동역학 예측 244

8.3 슈퍼 마리오브라더스 환경 설정 247

8.4 Q 신경망 전처리 250

8.5 Q 신경망과 정책 함수 설정 253

8.6 ICM(내재적 호기심 모듈) 257

8.7 그 밖의 내재적 보상 메커니즘들 271

요약 274

CHAPTER 9 다중 에이전트 강화학습 277

9.1 단일 에이전트에서 다중 에이전트로 278

9.2 이웃 Q 학습 282

9.3 1차원 이징 모형 286

9.4 평균장 Q 학습과 2차원 이징 모형 298

9.5 혼합 협조-경쟁 게임 309

요약 323

CHAPTER 10 해석 가능한 강화학습: 주의 모형과 관계 모형 325

10.1 주의와 관계 편향을 이용한 기계학습 해석성 개선 326

10.2 주의 메커니즘을 이용한 관계 추론 330

10.3 MNIST 이미지 분류를 위한 자가 주의 모형 구현 342

10.4 다중 헤드 주의 모형과 관계 DQN 356

10.5 이중 Q 학습 365

10.6 훈련과 주의 시각화 367

요약 376

CHAPTER 11 결론: 돌아보기와 내다보기 379

11.1 핵심 정리 380

11.2 심층 강화학습 분야의 미개척 주제들 382

11.3 마치며 386

APPENDIX A 수학, 심층학습, PyTorch 387

A.1 선형대수 388

A.2 미적분 390

A.3 심층학습 396A.4 PyTorch 397

참고문헌 402

찾아보기 406

책속으로

이 책을 출간하는 시점에서 본문에 수록된 모든 예제 코드는 잘 작동함이 확인된 것이다. 그러나 심층학습 분야와 관련 라이브러리들이 빠르게 발전하는 만큼, 언제까지라도 예제 코드가 의도대로 작동하리라는 보장은 없다. 본문의 예제 코드는 또한 프로젝트가 돌아가는 데 필요한 최소한의 형태로만 작성된 것일 뿐이므로, 원서 깃허브 저장소 http://mng.bz/JzKp에 있는 좀 더 완전한(그리고 갱신된) 소스 코드를 참고하길 강력히 권한다. _xvi쪽이 책은 독자가 심층학습에 관한 기본 지식을 어느 정도 갖추고 있다고 가정하지만, 재미있고 유익한 강화학습 기법들을 배우는 과정에서 여러분의 심층학습 관련 기술도 더욱 제련될 것이다. 좀 더 어려운 프로젝트들을 해결하기 위해서는 심층학습의 최신 성과 몇 가지도 동원할 필요가 있다. 이를테면 GAN(생성 대립 신경망 또는 생성적 적대 신경망), 진화적 방법들, 메타 학습, 전이학습이 그런 예이다. 물론 이들은 모두 독자의 추후 학습 능력을 증진한다는 기본적인 목적하에서 언급되는 것일 뿐, 그런 최신 성과의 기술적인 세부 사항에 초점들을 두지는 않는다. _23쪽실망스럽지만 흥미로운 결과이다. 신경망이 선택한 이동 동작들을 자세히 살펴보기 바란다. 플레이어는 목표에서 오른 쪽으로 몇 타일 떨어진 곳에서 출발한다. 플레이어가 게임 플레이 방법을 정말로 알고 있다면 그냥 왼쪽으로 직진해서 목표에 도달했을 것이다. 그러나 플레이어는 정적 모드에서처럼 아래로 내려가기 시작한다. 이 결과를 보면 신경망이 훈련에 사용한 정적 모드의 게임 플레이를 그냥 암기했을 뿐, 배운 것을 일반화하지는 못했다고 봐야 할 것이다. _84쪽그림 5.10은 행위자-비평자 알고리즘의 개요이다. 행위자-비평자 모형은 상태 가치와 동작 확률분포를 산출해야 한다. 동작 확률분포로 동작을 선택해서 보상을 받고, 그것을 상태 가치와 비교해서 이익을 계산한다. 궁극적으로 동작을 강화하고 모형을 훈련하는 데 사용하는 것은 바로 그 이익이다. _143쪽그림 7.14에서 보듯이 균등분포가 분산이 훨씬 작은, 5를 중심으로 한 정규분포 비슷한 분포로 바뀌었다. 이상의 실험으로 볼 때 update_dist 함수는 의도한 대로 잘 작동하는 것으로 보인다. 이번 예제에서 이 함수는 분포 DQN이 근사하고자 하는 목표 분포를 생성하는 데 쓰인다. 그럼 프리웨이 게임을 위한 분포 DQN을 구현해 보자. _215쪽1차원 이징 모형은 아주 간단하기 때문에, PyTorch의 내장 신경망 층들을 사용하는 대신 관련된 모든 행렬 곱셈 연산을 직접 지정해서 신경망을 작성해도 별로 어렵지 않다. 목록 9.5는 Q 신경망(Q 함수)을 구현하는 파이썬 함수이다. 이 함수는 상태 벡터 하나와 매개변수 벡터를 받고, 매개변수 벡터에 담긴 매개변수들을 여러 개의 행렬로 만들어서 각각의 신경망 층으로 사용한다. _292쪽

출판사 서평

프로젝트로 배우는 심층 강화학습의 이론과 실제!심층 강화학습 시스템은 새로운 환경에 빠르게 적응한다. 이러한 능력은 기존의 표준적인 신경망에 비해 커다란 진보에 해당한다. 사람이 뭔가를 배우는 과정과 비슷하게, 심층 강화학습 에이전트는 감각 정보에 해당하는 원본 데이터를 입력받고 시행착오를 거쳐서 자신의 반응과 예측을 정련해 나간다.이 책 《심층 강화학습 인 액션》은 환경이 제공하는 직접적인 피드백에 기반해서 환경에 적응하고 자신을 개선해 나가는 에이전트의 구현 방법을 설명한다. 흐름이 있는 하나의 강좌 형태로 구성된 이 책에서 여러분은 심층 강화학습의 기본 기법과 고급 기법을 미로 탈출이나 비디오 게임 플레이 같은 흥미로운 예제를 통해서 배우게 된다. 그 과정에서 심층 Q 신경망과 정책 기울기 방법을 포함한 여러 핵심 알고리즘을 익힐 수 있고, PyTorch와 OpenAI Gym 같은 업계 표준에 해당하는 라이브러리에도 익숙해질 것이다.이 책의 주요 내용

■ 심층 강화학습 에이전트의 구축과 훈련

■ 학습과 문제 해결에 가장 널리 쓰이는 심층 강화학습 알고리즘

■ 진화 알고리즘, 호기심 기반 학습, 다중 에이전트 학습 등의 고급 주제

■ 실행 가능한 파이썬 예제 코드

■ 심층 강화학습 에이전트의 구축과 훈련

■ 학습과 문제 해결에 가장 널리 쓰이는 심층 강화학습 알고리즘

■ 진화 알고리즘, 호기심 기반 학습, 다중 에이전트 학습 등의 고급 주제

■ 실행 가능한 파이썬 예제 코드

상품 정보 고시

| 도서명 | 심층 강화학습 인 액션 |

|---|---|

| 저자 | 알렉스 짜이 , 브랜던 브라운 |

| 출판사 | 제이펍 |

| ISBN | 9791190665612 (1190665611) |

| 쪽수 | 440 |

| 출간일 | 2020-11-17 |

| 사이즈 | 189 * 245 * 31 mm /930g |

| 목차 또는 책소개 | PART I 기초 1 CHAPTER 1 강화학습이란? 3 1.1 심층 강화학습에서 ‘심층’의 의미 4 1.2 강화학습 6 1.3 동적 계획법과 몬테카를로 방법 9 1.4 강화학습의 틀 12 1.5 강화학습으로 할 수 있는 일 16 1.6 왜 심층 강화학습인가? 18 1.7 이 책의 주요 설명 수단: 끈 그림 21 1.8 앞으로의 여정 22 요약 24 CHAPTER 2 강화학습 문제의 모형화: 마르코프 결정 과정 25 2.1 끈 그림과 이 책의 교육 방식 25 2.2 여러 팔 강도 문제의 해법 30 2.3 여러 팔 강도 문제를 광고 배치 최적화에 적용 41 2.4 PyTorch로 신경망 만들기 43 2.5 문맥적 강도 문제의 해법 47 2.6 마르코프 성질 52 2.7 향후 보상의 예측: 가치와 정책 함수 55 요약 59 CHAPTER 3 가장 나은 동작의 선택: 심층 Q 신경망(DQN) 61 3.1 Q 함수 62 3.2 Q 학습 개요 64 3.3 파국적 망각 방지: 경험 재현 85 3.4 목표망을 이용한 안정성 개선 92 3.5 정리 99 요약 102 CHAPTER 4 정책 기울기 방법 103 4.1 신경망을 이용한 정책 함수 구현 104 4.2 좋은 동작의 강화: 정책 기울기 알고리즘 108 4.3 OpenAI Gym 다루기 114 4.4 REINFORCE 알고리즘 117 요약 125 CHAPTER 5 좀 더 어려운 문제 풀기: 행위자-비평자 모형 127 5.1 가치 함수와 정책 함수의 결합 129 5.2 분산 훈련 135 5.3 이익 행위자-비평자 141 5.4 N-단계 행위자-비평자 151 요약 157 PART I I 더 높은 곳을 향하여 159 CHAPTER 6 또 다른 최적화 방법: 진화 알고리즘 161 6.1 강화학습의 또 다른 접근 방식 162 6.2 진화를 이용한 강화학습 163 6.3 CartPole을 위한 유전 알고리즘 172 6.4 진화 알고리즘의 장단점 180 6.5 규모가변적 대안으로서의 진화 알고리즘 182 6.5.6 기울기 기반 접근 방식의 규모 확장 189 요약 189 CHAPTER 7 모든 가능성의 탐색: 분포 심층 Q 신경망 191 7.1 기댓값 Q 학습의 문제점 192 7.2 다시 살펴보는 확률과 통계 197 7.3 벨먼 방정식 204 7.4 분포 Q 학습 206 7.5 확률분포의 비교 219 7.6 가상의 데이터에 대한 분포 DQN 225 7.7 분포 DQN을 이용한 아타리 프리웨이 학습 231 요약 237 CHAPTER 8 호기심 주도 탐험 239 8.1 예측 부호화를 이용한 희소 보상 문제 해결 241 8.2 역방향 동역학 예측 244 8.3 슈퍼 마리오브라더스 환경 설정 247 8.4 Q 신경망 전처리 250 8.5 Q 신경망과 정책 함수 설정 253 8.6 ICM(내재적 호기심 모듈) 257 8.7 그 밖의 내재적 보상 메커니즘들 271 요약 274 CHAPTER 9 다중 에이전트 강화학습 277 9.1 단일 에이전트에서 다중 에이전트로 278 9.2 이웃 Q 학습 282 9.3 1차원 이징 모형 286 9.4 평균장 Q 학습과 2차원 이징 모형 298 9.5 혼합 협조-경쟁 게임 309 요약 323 CHAPTER 10 해석 가능한 강화학습: 주의 모형과 관계 모형 325 10.1 주의와 관계 편향을 이용한 기계학습 해석성 개선 326 10.2 주의 메커니즘을 이용한 관계 추론 330 10.3 MNIST 이미지 분류를 위한 자가 주의 모형 구현 342 10.4 다중 헤드 주의 모형과 관계 DQN 356 10.5 이중 Q 학습 365 10.6 훈련과 주의 시각화 367 요약 376 CHAPTER 11 결론: 돌아보기와 내다보기 379 11.1 핵심 정리 380 11.2 심층 강화학습 분야의 미개척 주제들 382 11.3 마치며 386 APPENDIX A 수학, 심층학습, PyTorch 387 A.1 선형대수 388 A.2 미적분 390 A.3 심층학습 396A.4 PyTorch 397 참고문헌 402 찾아보기 406 |

사용후기

회원리뷰 총 0개

사용후기가 없습니다.

상품문의

등록된 상품문의

상품문의 총 0개

상품문의가 없습니다.

교환/반품

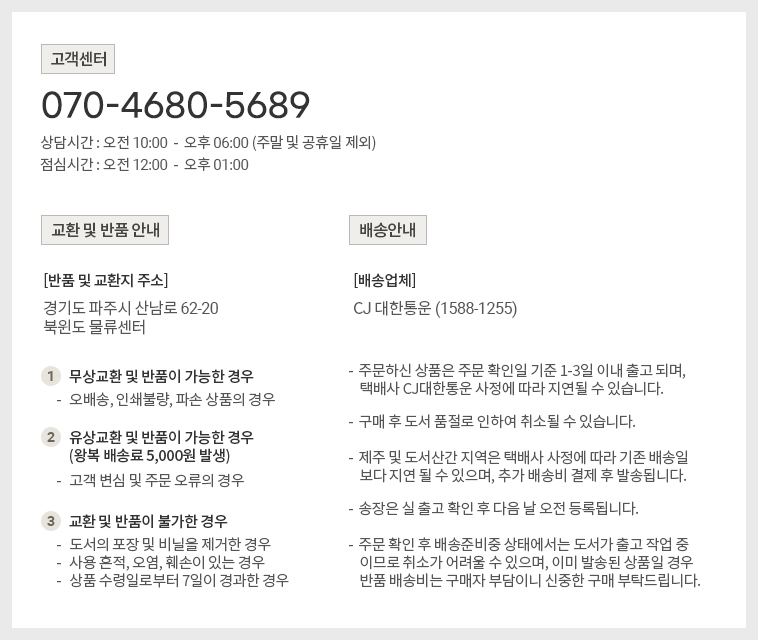

[반품/교환방법]

마이페이지> 주문배송조회 > 반품/교환신청 또는 고객센터 (070-4680-5689)로 문의 바랍니다.

[반품주소]

- 도로명 : (10882) 경기도 파주시 산남로 62-20 (산남동)

- 지번 : (10882) 경기도 파주시 산남동 305-21

[반품/교환가능 기간]

변심반품의 경우 수령 후 14일 이내, 상품의 결함 및 계약내용과 다를 경우 문제점 발견 후 30일 이내

[반품/교환비용]

단순 변심 혹은 구매착오로 인한 반품/교환은 반송료 고객 부담

[반품/교환 불가 사유]

- 소비자의 책임 있는 사유로 상품 등이 손실 또는 훼손된 경우

(단지 확인을 위한 포장 훼손은 제외)

- 소비자의 사용, 포장 개봉에 의해 상품 등의 가치가 현저히 감소한 경우

예) 화장품, 식품, 가전제품(악세서리 포함) 등

- 복제가 가능한 상품 등의 포장을 훼손한 경우

예) 음반/DVD/비디오, 소프트웨어, 만화책, 잡지, 영상 화보집

- 소비자의 요청에 따라 개별적으로 주문 제작되는 상품의 경우 ((1)해외주문도서)

- 디지털 컨텐츠인 eBook, 오디오북 등을 1회 이상 다운로드를 받았을 경우

- 시간의 경과에 의해 재판매가 곤란한 정도로 가치가 현저히 감소한 경우

- 전자상거래 등에서의 소비자보호에 관한 법률이 정하는 소비자 청약철회 제한 내용에 해당되는 경우

* (1) 해외주문도서 : 이용자의 요청에 의한 개인주문상품으로 단순변심 및 착오로 인한 취소/교환/반품 시

‘해외주문 반품/취소 수수료’ 고객 부담 (해외주문 반품/취소 수수료 : ①양서-판매정가의 12%, ②일서-판매정가의 7%를 적용)

[상품 품절]

공급사(출판사) 재고 사정에 의해 품절/지연될 수 있으며, 품절 시 관련 사항에 대해서는 이메일과 문자로 안내드리겠습니다.

[소비자 피해보상, 환불지연에 따른 배상]

- 상품의 불량에 의한 교환, A/S, 환불, 품질보증 및 피해보상 등에 관한 사항은 소비자분쟁해결 기준 (공정거래위원회 고시)에 준하여 처리됩니다.

- 대금 환불 및 환불지연에 따른 배상금 지급 조건, 절차 등은 전자상거래 등에서의 소비자 보호에 관한 법률에 따라 처리함.

![[출간예정] Do it! 스위프트로 아이폰 앱 만들기: 입문](http://211.169.249.153/data/item/9791163032168/thumb-9791163032168_60x60.jpg)

![[예약판매] 실무에 바로 쓰는 일잘러의 보고서 작성법](http://211.169.249.153/data/item/9791190665629/thumb-9791190665629_60x60.jpg)