상품 정보

상품 기본설명

대용량 데이터 처리부터 머신러닝까지

상품 상세설명

스파크를 처음 접하는 입문자를 위한 안내서!

하둡으로 대표되던 빅데이터 처리 기술은 빅데이터와 머신러닝, 딥러닝의 붐을 타고 믿을 수 없을 만큼 빠른 속도로 발전해가고 있습니다. 작년 봄 이 책의 초판이 출시되던 해에 스파크는 이미 최고의 데이터 처리 플랫폼 중 하나로 인정받고 있었습니다. 하지만 더 이상 큰 폭의 개편은 없을 것만 같았던 스파크는 그 후로도 더욱 주목할 만한 변화를 거듭하면서 불과 1년이 지난 지금 더욱더 새로워진 API와 고도화된 성능을 갖춘 최적의 데이터 처리 플랫폼으로 변화를 거듭하고 있습니다. 이 책은 스파크를 처음 접하는 개발자들이 빠른 시간 내에 스파크가 무엇이고 어디에 어떻게 활용할 수 있는지 실무에 필요한 감을 잡을 수 있도록 스파크의 전체 모듈에 대한 설명과 예제를 담고 있습니다. 특히 스파크를 써 보고 싶지만 새로운 언어를 배우는 데 따르는 부담 때문에 망설이던 개발자들을 위해 스칼라, 자바, 파이썬 예제를 수록했습니다. 이 책을 통해 스파크에 대한 기초를 다지고 나면 각자의 영역에서 스파크가 제공하는 풍부한 기능들을 더 깊이 있고 자유롭게 활용할 수 있게 될 것입니다.

하둡으로 대표되던 빅데이터 처리 기술은 빅데이터와 머신러닝, 딥러닝의 붐을 타고 믿을 수 없을 만큼 빠른 속도로 발전해가고 있습니다. 작년 봄 이 책의 초판이 출시되던 해에 스파크는 이미 최고의 데이터 처리 플랫폼 중 하나로 인정받고 있었습니다. 하지만 더 이상 큰 폭의 개편은 없을 것만 같았던 스파크는 그 후로도 더욱 주목할 만한 변화를 거듭하면서 불과 1년이 지난 지금 더욱더 새로워진 API와 고도화된 성능을 갖춘 최적의 데이터 처리 플랫폼으로 변화를 거듭하고 있습니다. 이 책은 스파크를 처음 접하는 개발자들이 빠른 시간 내에 스파크가 무엇이고 어디에 어떻게 활용할 수 있는지 실무에 필요한 감을 잡을 수 있도록 스파크의 전체 모듈에 대한 설명과 예제를 담고 있습니다. 특히 스파크를 써 보고 싶지만 새로운 언어를 배우는 데 따르는 부담 때문에 망설이던 개발자들을 위해 스칼라, 자바, 파이썬 예제를 수록했습니다. 이 책을 통해 스파크에 대한 기초를 다지고 나면 각자의 영역에서 스파크가 제공하는 풍부한 기능들을 더 깊이 있고 자유롭게 활용할 수 있게 될 것입니다.

목차

▣ 01장: 스파크 소개

1.1 스파크

___1.1.1 빅데이터의 등장

___1.1.2 빅데이터의 정의

___1.1.3 빅데이터 솔루션

___1.1.4 스파크

___1.1.5 RDD(Resilient Distributed Dataset) 소개와 연산

___1.1.6 DAG

___1.1.7 람다 아키텍처

1.2 스파크 설치

___1.2.1 스파크 실행 모드의 이해

___1.2.2 사전 준비

___1.2.3 스파크 설치

___1.2.4 예제 실행

___1.2.5 스파크 셸

___1.2.6 실행 옵션

___1.2.7 더 살펴보기

1.3 개발 환경 구축

___1.3.1 로컬 개발 환경 구축

1.4 예제 프로젝트 설정

___1.4.1 WordCount 예제 실행

1.5 데이터프레임과 데이터셋

1.6 정리

▣ 02장: RDD

2.1 RDD

___2.1.1 들어가기에 앞서

___2.1.2 스파크컨텍스트 생성

___2.1.3 RDD 생성

___2.1.4 RDD 기본 액션

___2.1.5 RDD 트랜스포메이션

___2.1.6 RDD 액션

___2.1.7 RDD 데이터 불러오기와 저장하기

___2.1.8 클러스터 환경에서의 공유 변수

2.2 정리

▣ 03장: 클러스터 환경

3.1 클러스터 환경

___3.1.1 클러스터 모드와 컴포넌트

___3.1.2 클러스터 모드를 위한 시스템 구성

___3.1.3 드라이버 프로그램과 디플로이 모드

3.2 클러스터 매니저

___3.2.1 스탠드얼론 클러스터 매니저

___3.2.2 아파치 메소스

___3.2.3 얀

___3.2.4 히스토리 서버와 매트릭스

___3.2.5 쿠버네티스(Kubenetes)

3.3 정리

▣ 04장: 스파크 설정

4.1 스파크 프로퍼티

4.2 환경변수

4.3 로깅 설정

4.4 스케줄링

___4.4.1 애플리케이션 간의 자원 스케줄링

___4.4.2 단일 애플리케이션 내부에서의 자원 스케줄링

4.5 정리

▣ 05장: 스파크 SQL

5.1 데이터셋

5.2 연산의 종류와 주요 API

5.3 코드 작성 절차 및 단어 수 세기 예제

5.4 스파크세션

5.5 데이터프레임, 로우, 칼럼

___5.5.1 데이터프레임 생성

___5.5.2 주요 연산 및 사용법

5.6 데이터셋

___5.6.1 데이터셋 생성

___5.6.2 타입 트랜스포메이션 연산

5.7 하이브 연동

5.8 분산 SQL 엔진

5.9 Spark SQL CLI

5.10 쿼리플랜(Query Plan)과 디버깅

___5.10.1 스파크세션(SparkSession)과 세션스테이트(SessionState), 스파크컨텍스트(SparkContext)

___5.10.2 QueryExecution

___5.10.3 LogicalPlan과 SparkPlan

5.11 정리

▣ 06장: 스파크 스트리밍

6.1 개요 및 주요 용어

6.1.1 스트리밍컨텍스트

___6.1.2 DStream(Discretized Streams)

6.2 데이터 읽기

___6.2.1 소켓

___6.2.2 파일

___6.2.3 RDD 큐(Queue of RDD)

___6.2.4 카프카

6.3 데이터 다루기(기본 연산)

___6.3.1 print()

___6.3.2 map(func)

___6.3.3 flatMap(func)

___6.3.4 count(), countByValue()

___6.3.5 reduce(func), reduceByKey(func)

___6.3.6 filter(func)

___6.3.7 union()

___6.3.8 join()

6.4 데이터 다루기(고급 연산)

___6.4.1 transform(func)

___6.4.2 updateStateByKey()

___6.4.3 윈도우 연산

___6.4.4 window(windowLength, slideInterval)

___6.4.5 countByWindow(windowLength, slideInterval)

___6.4.6 reduceByWindow(func, windowLength, slideInterval)

___6.4.7 reduceByKeyAndWindow(func, invFunc, windowLength, slideInterval, [numTasks])

___6.4.8 countByValueAndWindow(windowLength, slideInterval, [numTasks])

6.5 데이터의 저장

___6.5.1 saveAsTextFiles(), saveAsObjectFiles(), saveAsHadoopFiles()

___6.5.2 foreachRDD()

6.6 CheckPoint

6.7 캐시

6.8 모니터링

6.9 주요 설정

▣ 07장: 스트럭처 스트리밍

7.1 개요

7.2 프로그래밍 절차

7.3 데이터프레임과 데이터셋 생성

7.4 스트리밍 연산

___7.4.1 기본 연산 및 집계 연산

___7.4.2 윈도우 연산

___7.4.3 워터마킹

___7.4.4 조인 연산

___7.4.5 스트리밍 중복 데이터 제거

___7.4.6 스트리밍 쿼리

7.5 정리

▣ 08장: MLlib

8.1 개요

8.2 관측과 특성

8.3 레이블

8.4 연속형 데이터와 이산형 데이터

8.5 알고리즘과 모델

8.6 파라메트릭 알고리즘

8.7 지도학습과 비지도학습

8.8 훈련 데이터와 테스트 데이터

8.9 MLlib API

8.10 의존성 설정

8.11 벡터와 LabeledPoint

___8.11.1 벡터

___8.11.2 LabeledPoint

8.12 파이프라인

8.13 알고리즘

___8.13.1 Tokenizer

___8.13.2 TF-IDF

___8.13.3 StringIndexer, IndexToString

8.14 회귀와 분류

___8.14.1 회귀

___8.14.2 분류

8.15 클러스터링

8.16 협업 필터링

8.17 정리

▣ 09장: SparkR

9.1 개요

9.2 R 설치 및 실행

9.3 데이터프레임

9.4 데이터프레임 생성

___9.4.1 R데이터프레임으로부터 생성

___9.4.2 파일로부터 생성

9.5 데이터프레임 연산

___9.5.1 조회 및 기본 연산

___9.5.2 그룹 및 집계 연산

___9.5.3 칼럼 연산

___9.5.4 집합 연산

___9.5.5 dapply(), dapplyCollect()

___9.5.6 gapply(), gapplyCollect()

___9.5.7 spark.lapply()

___9.5.8 createOrReplaceTempView()

___9.5.9 write()

9.6 하이브 연동

9.7 머신러닝

9.8 정리

▣ 10장: GraphX

10.1 주요 용어

___10.1.1 유방향 그래프

___10.1.2 유방향 멀티 그래프

___10.1.3 속성 그래프

10.2 데이터 타입

___10.2.1 RDD

___10.2.2 VertextID

___10.2.3 꼭짓점

___10.2.4 선(Edge)

___10.2.5 EdgeTriplet

___10.2.6 VertexRDD

___10.2.7 EdgeRDD

___10.2.8 Graph

10.3 그래프 생성

10.4 그래프 연산

___10.4.1 numEdges, numVertices

___10.4.2 inDegrees, outDegrees, degrees

___10.4.3 vertices, edges, triplets

___10.4.4 mapVertices(), mapEdges(), mapTriplets()

___10.4.5 reverse()

___10.4.6 subgraph()

___10.4.7 mask()

___10.4.8 groupEdges()

___10.4.9 joinVertices(), outerJoinVertices()

___10.4.10 collectNeighborIds(), collectNeighbors()

___10.4.11 aggregateMessages()

___10.4.12 pregel()

10.5 VertextRDD, EdgeRDD 연산

10.6 그래프 알고리즘

10.7 정리

▣ 부록: 스칼라란?

스칼라 설치

스칼라 셸

변수 타입과 변수 선언

Range와 형변환

클래스, 객체, 컴패니언 오브젝트

트레이트와 상속

apply

튜플과 옵션, 케이스클래스

패턴 매치

패키지 객체

type

임포트

함수와 메서드

제네릭

암묵적 변환과 타입 클래스 패턴

정리

1.1 스파크

___1.1.1 빅데이터의 등장

___1.1.2 빅데이터의 정의

___1.1.3 빅데이터 솔루션

___1.1.4 스파크

___1.1.5 RDD(Resilient Distributed Dataset) 소개와 연산

___1.1.6 DAG

___1.1.7 람다 아키텍처

1.2 스파크 설치

___1.2.1 스파크 실행 모드의 이해

___1.2.2 사전 준비

___1.2.3 스파크 설치

___1.2.4 예제 실행

___1.2.5 스파크 셸

___1.2.6 실행 옵션

___1.2.7 더 살펴보기

1.3 개발 환경 구축

___1.3.1 로컬 개발 환경 구축

1.4 예제 프로젝트 설정

___1.4.1 WordCount 예제 실행

1.5 데이터프레임과 데이터셋

1.6 정리

▣ 02장: RDD

2.1 RDD

___2.1.1 들어가기에 앞서

___2.1.2 스파크컨텍스트 생성

___2.1.3 RDD 생성

___2.1.4 RDD 기본 액션

___2.1.5 RDD 트랜스포메이션

___2.1.6 RDD 액션

___2.1.7 RDD 데이터 불러오기와 저장하기

___2.1.8 클러스터 환경에서의 공유 변수

2.2 정리

▣ 03장: 클러스터 환경

3.1 클러스터 환경

___3.1.1 클러스터 모드와 컴포넌트

___3.1.2 클러스터 모드를 위한 시스템 구성

___3.1.3 드라이버 프로그램과 디플로이 모드

3.2 클러스터 매니저

___3.2.1 스탠드얼론 클러스터 매니저

___3.2.2 아파치 메소스

___3.2.3 얀

___3.2.4 히스토리 서버와 매트릭스

___3.2.5 쿠버네티스(Kubenetes)

3.3 정리

▣ 04장: 스파크 설정

4.1 스파크 프로퍼티

4.2 환경변수

4.3 로깅 설정

4.4 스케줄링

___4.4.1 애플리케이션 간의 자원 스케줄링

___4.4.2 단일 애플리케이션 내부에서의 자원 스케줄링

4.5 정리

▣ 05장: 스파크 SQL

5.1 데이터셋

5.2 연산의 종류와 주요 API

5.3 코드 작성 절차 및 단어 수 세기 예제

5.4 스파크세션

5.5 데이터프레임, 로우, 칼럼

___5.5.1 데이터프레임 생성

___5.5.2 주요 연산 및 사용법

5.6 데이터셋

___5.6.1 데이터셋 생성

___5.6.2 타입 트랜스포메이션 연산

5.7 하이브 연동

5.8 분산 SQL 엔진

5.9 Spark SQL CLI

5.10 쿼리플랜(Query Plan)과 디버깅

___5.10.1 스파크세션(SparkSession)과 세션스테이트(SessionState), 스파크컨텍스트(SparkContext)

___5.10.2 QueryExecution

___5.10.3 LogicalPlan과 SparkPlan

5.11 정리

▣ 06장: 스파크 스트리밍

6.1 개요 및 주요 용어

6.1.1 스트리밍컨텍스트

___6.1.2 DStream(Discretized Streams)

6.2 데이터 읽기

___6.2.1 소켓

___6.2.2 파일

___6.2.3 RDD 큐(Queue of RDD)

___6.2.4 카프카

6.3 데이터 다루기(기본 연산)

___6.3.1 print()

___6.3.2 map(func)

___6.3.3 flatMap(func)

___6.3.4 count(), countByValue()

___6.3.5 reduce(func), reduceByKey(func)

___6.3.6 filter(func)

___6.3.7 union()

___6.3.8 join()

6.4 데이터 다루기(고급 연산)

___6.4.1 transform(func)

___6.4.2 updateStateByKey()

___6.4.3 윈도우 연산

___6.4.4 window(windowLength, slideInterval)

___6.4.5 countByWindow(windowLength, slideInterval)

___6.4.6 reduceByWindow(func, windowLength, slideInterval)

___6.4.7 reduceByKeyAndWindow(func, invFunc, windowLength, slideInterval, [numTasks])

___6.4.8 countByValueAndWindow(windowLength, slideInterval, [numTasks])

6.5 데이터의 저장

___6.5.1 saveAsTextFiles(), saveAsObjectFiles(), saveAsHadoopFiles()

___6.5.2 foreachRDD()

6.6 CheckPoint

6.7 캐시

6.8 모니터링

6.9 주요 설정

▣ 07장: 스트럭처 스트리밍

7.1 개요

7.2 프로그래밍 절차

7.3 데이터프레임과 데이터셋 생성

7.4 스트리밍 연산

___7.4.1 기본 연산 및 집계 연산

___7.4.2 윈도우 연산

___7.4.3 워터마킹

___7.4.4 조인 연산

___7.4.5 스트리밍 중복 데이터 제거

___7.4.6 스트리밍 쿼리

7.5 정리

▣ 08장: MLlib

8.1 개요

8.2 관측과 특성

8.3 레이블

8.4 연속형 데이터와 이산형 데이터

8.5 알고리즘과 모델

8.6 파라메트릭 알고리즘

8.7 지도학습과 비지도학습

8.8 훈련 데이터와 테스트 데이터

8.9 MLlib API

8.10 의존성 설정

8.11 벡터와 LabeledPoint

___8.11.1 벡터

___8.11.2 LabeledPoint

8.12 파이프라인

8.13 알고리즘

___8.13.1 Tokenizer

___8.13.2 TF-IDF

___8.13.3 StringIndexer, IndexToString

8.14 회귀와 분류

___8.14.1 회귀

___8.14.2 분류

8.15 클러스터링

8.16 협업 필터링

8.17 정리

▣ 09장: SparkR

9.1 개요

9.2 R 설치 및 실행

9.3 데이터프레임

9.4 데이터프레임 생성

___9.4.1 R데이터프레임으로부터 생성

___9.4.2 파일로부터 생성

9.5 데이터프레임 연산

___9.5.1 조회 및 기본 연산

___9.5.2 그룹 및 집계 연산

___9.5.3 칼럼 연산

___9.5.4 집합 연산

___9.5.5 dapply(), dapplyCollect()

___9.5.6 gapply(), gapplyCollect()

___9.5.7 spark.lapply()

___9.5.8 createOrReplaceTempView()

___9.5.9 write()

9.6 하이브 연동

9.7 머신러닝

9.8 정리

▣ 10장: GraphX

10.1 주요 용어

___10.1.1 유방향 그래프

___10.1.2 유방향 멀티 그래프

___10.1.3 속성 그래프

10.2 데이터 타입

___10.2.1 RDD

___10.2.2 VertextID

___10.2.3 꼭짓점

___10.2.4 선(Edge)

___10.2.5 EdgeTriplet

___10.2.6 VertexRDD

___10.2.7 EdgeRDD

___10.2.8 Graph

10.3 그래프 생성

10.4 그래프 연산

___10.4.1 numEdges, numVertices

___10.4.2 inDegrees, outDegrees, degrees

___10.4.3 vertices, edges, triplets

___10.4.4 mapVertices(), mapEdges(), mapTriplets()

___10.4.5 reverse()

___10.4.6 subgraph()

___10.4.7 mask()

___10.4.8 groupEdges()

___10.4.9 joinVertices(), outerJoinVertices()

___10.4.10 collectNeighborIds(), collectNeighbors()

___10.4.11 aggregateMessages()

___10.4.12 pregel()

10.5 VertextRDD, EdgeRDD 연산

10.6 그래프 알고리즘

10.7 정리

▣ 부록: 스칼라란?

스칼라 설치

스칼라 셸

변수 타입과 변수 선언

Range와 형변환

클래스, 객체, 컴패니언 오브젝트

트레이트와 상속

apply

튜플과 옵션, 케이스클래스

패턴 매치

패키지 객체

type

임포트

함수와 메서드

제네릭

암묵적 변환과 타입 클래스 패턴

정리

상품 정보 고시

| 도서명 | 빅데이터 분석을 위한 스파크2 프로그래밍 |

|---|---|

| 저자 | 백성민 |

| 출판사 | 위키북스 |

| ISBN | 9791158391034 (115839103X) |

| 쪽수 | 644 |

| 출간일 | 2018-04-12 |

| 사이즈 | 189 * 241 * 35 mm /1209g |

| 목차 또는 책소개 | ▣ 01장: 스파크 소개 1.1 스파크 ___1.1.1 빅데이터의 등장 ___1.1.2 빅데이터의 정의 ___1.1.3 빅데이터 솔루션 ___1.1.4 스파크 ___1.1.5 RDD(Resilient Distributed Dataset) 소개와 연산 ___1.1.6 DAG ___1.1.7 람다 아키텍처 1.2 스파크 설치 ___1.2.1 스파크 실행 모드의 이해 ___1.2.2 사전 준비 ___1.2.3 스파크 설치 ___1.2.4 예제 실행 ___1.2.5 스파크 셸 ___1.2.6 실행 옵션 ___1.2.7 더 살펴보기 1.3 개발 환경 구축 ___1.3.1 로컬 개발 환경 구축 1.4 예제 프로젝트 설정 ___1.4.1 WordCount 예제 실행 1.5 데이터프레임과 데이터셋 1.6 정리 ▣ 02장: RDD 2.1 RDD ___2.1.1 들어가기에 앞서 ___2.1.2 스파크컨텍스트 생성 ___2.1.3 RDD 생성 ___2.1.4 RDD 기본 액션 ___2.1.5 RDD 트랜스포메이션 ___2.1.6 RDD 액션 ___2.1.7 RDD 데이터 불러오기와 저장하기 ___2.1.8 클러스터 환경에서의 공유 변수 2.2 정리 ▣ 03장: 클러스터 환경 3.1 클러스터 환경 ___3.1.1 클러스터 모드와 컴포넌트 ___3.1.2 클러스터 모드를 위한 시스템 구성 ___3.1.3 드라이버 프로그램과 디플로이 모드 3.2 클러스터 매니저 ___3.2.1 스탠드얼론 클러스터 매니저 ___3.2.2 아파치 메소스 ___3.2.3 얀 ___3.2.4 히스토리 서버와 매트릭스 ___3.2.5 쿠버네티스(Kubenetes) 3.3 정리 ▣ 04장: 스파크 설정 4.1 스파크 프로퍼티 4.2 환경변수 4.3 로깅 설정 4.4 스케줄링 ___4.4.1 애플리케이션 간의 자원 스케줄링 ___4.4.2 단일 애플리케이션 내부에서의 자원 스케줄링 4.5 정리 ▣ 05장: 스파크 SQL 5.1 데이터셋 5.2 연산의 종류와 주요 API 5.3 코드 작성 절차 및 단어 수 세기 예제 5.4 스파크세션 5.5 데이터프레임, 로우, 칼럼 ___5.5.1 데이터프레임 생성 ___5.5.2 주요 연산 및 사용법 5.6 데이터셋 ___5.6.1 데이터셋 생성 ___5.6.2 타입 트랜스포메이션 연산 5.7 하이브 연동 5.8 분산 SQL 엔진 5.9 Spark SQL CLI 5.10 쿼리플랜(Query Plan)과 디버깅 ___5.10.1 스파크세션(SparkSession)과 세션스테이트(SessionState), 스파크컨텍스트(SparkContext) ___5.10.2 QueryExecution ___5.10.3 LogicalPlan과 SparkPlan 5.11 정리 ▣ 06장: 스파크 스트리밍 6.1 개요 및 주요 용어 6.1.1 스트리밍컨텍스트 ___6.1.2 DStream(Discretized Streams) 6.2 데이터 읽기 ___6.2.1 소켓 ___6.2.2 파일 ___6.2.3 RDD 큐(Queue of RDD) ___6.2.4 카프카 6.3 데이터 다루기(기본 연산) ___6.3.1 print() ___6.3.2 map(func) ___6.3.3 flatMap(func) ___6.3.4 count(), countByValue() ___6.3.5 reduce(func), reduceByKey(func) ___6.3.6 filter(func) ___6.3.7 union() ___6.3.8 join() 6.4 데이터 다루기(고급 연산) ___6.4.1 transform(func) ___6.4.2 updateStateByKey() ___6.4.3 윈도우 연산 ___6.4.4 window(windowLength, slideInterval) ___6.4.5 countByWindow(windowLength, slideInterval) ___6.4.6 reduceByWindow(func, windowLength, slideInterval) ___6.4.7 reduceByKeyAndWindow(func, invFunc, windowLength, slideInterval, [numTasks]) ___6.4.8 countByValueAndWindow(windowLength, slideInterval, [numTasks]) 6.5 데이터의 저장 ___6.5.1 saveAsTextFiles(), saveAsObjectFiles(), saveAsHadoopFiles() ___6.5.2 foreachRDD() 6.6 CheckPoint 6.7 캐시 6.8 모니터링 6.9 주요 설정 ▣ 07장: 스트럭처 스트리밍 7.1 개요 7.2 프로그래밍 절차 7.3 데이터프레임과 데이터셋 생성 7.4 스트리밍 연산 ___7.4.1 기본 연산 및 집계 연산 ___7.4.2 윈도우 연산 ___7.4.3 워터마킹 ___7.4.4 조인 연산 ___7.4.5 스트리밍 중복 데이터 제거 ___7.4.6 스트리밍 쿼리 7.5 정리 ▣ 08장: MLlib 8.1 개요 8.2 관측과 특성 8.3 레이블 8.4 연속형 데이터와 이산형 데이터 8.5 알고리즘과 모델 8.6 파라메트릭 알고리즘 8.7 지도학습과 비지도학습 8.8 훈련 데이터와 테스트 데이터 8.9 MLlib API 8.10 의존성 설정 8.11 벡터와 LabeledPoint ___8.11.1 벡터 ___8.11.2 LabeledPoint 8.12 파이프라인 8.13 알고리즘 ___8.13.1 Tokenizer ___8.13.2 TF-IDF ___8.13.3 StringIndexer, IndexToString 8.14 회귀와 분류 ___8.14.1 회귀 ___8.14.2 분류 8.15 클러스터링 8.16 협업 필터링 8.17 정리 ▣ 09장: SparkR 9.1 개요 9.2 R 설치 및 실행 9.3 데이터프레임 9.4 데이터프레임 생성 ___9.4.1 R데이터프레임으로부터 생성 ___9.4.2 파일로부터 생성 9.5 데이터프레임 연산 ___9.5.1 조회 및 기본 연산 ___9.5.2 그룹 및 집계 연산 ___9.5.3 칼럼 연산 ___9.5.4 집합 연산 ___9.5.5 dapply(), dapplyCollect() ___9.5.6 gapply(), gapplyCollect() ___9.5.7 spark.lapply() ___9.5.8 createOrReplaceTempView() ___9.5.9 write() 9.6 하이브 연동 9.7 머신러닝 9.8 정리 ▣ 10장: GraphX 10.1 주요 용어 ___10.1.1 유방향 그래프 ___10.1.2 유방향 멀티 그래프 ___10.1.3 속성 그래프 10.2 데이터 타입 ___10.2.1 RDD ___10.2.2 VertextID ___10.2.3 꼭짓점 ___10.2.4 선(Edge) ___10.2.5 EdgeTriplet ___10.2.6 VertexRDD ___10.2.7 EdgeRDD ___10.2.8 Graph 10.3 그래프 생성 10.4 그래프 연산 ___10.4.1 numEdges, numVertices ___10.4.2 inDegrees, outDegrees, degrees ___10.4.3 vertices, edges, triplets ___10.4.4 mapVertices(), mapEdges(), mapTriplets() ___10.4.5 reverse() ___10.4.6 subgraph() ___10.4.7 mask() ___10.4.8 groupEdges() ___10.4.9 joinVertices(), outerJoinVertices() ___10.4.10 collectNeighborIds(), collectNeighbors() ___10.4.11 aggregateMessages() ___10.4.12 pregel() 10.5 VertextRDD, EdgeRDD 연산 10.6 그래프 알고리즘 10.7 정리 ▣ 부록: 스칼라란? 스칼라 설치 스칼라 셸 변수 타입과 변수 선언 Range와 형변환 클래스, 객체, 컴패니언 오브젝트 트레이트와 상속 apply 튜플과 옵션, 케이스클래스 패턴 매치 패키지 객체 type 임포트 함수와 메서드 제네릭 암묵적 변환과 타입 클래스 패턴 정리 |

상품 정보 고시

| 도서명 | 상품페이지 참고 |

|---|---|

| 저자 | 상품페이지 참고 |

| 출판사 | 상품페이지 참고 |

| 크기 | 상품페이지 참고 |

| 쪽수 | 상품페이지 참고 |

| 제품구성 | 상품페이지 참고 |

| 출간일 | 상품페이지 참고 |

| 목차 또는 책소개 | 상품페이지 참고 |

사용후기

회원리뷰 총 0개

사용후기가 없습니다.

상품문의

등록된 상품문의

상품문의 총 0개

상품문의가 없습니다.

교환/반품

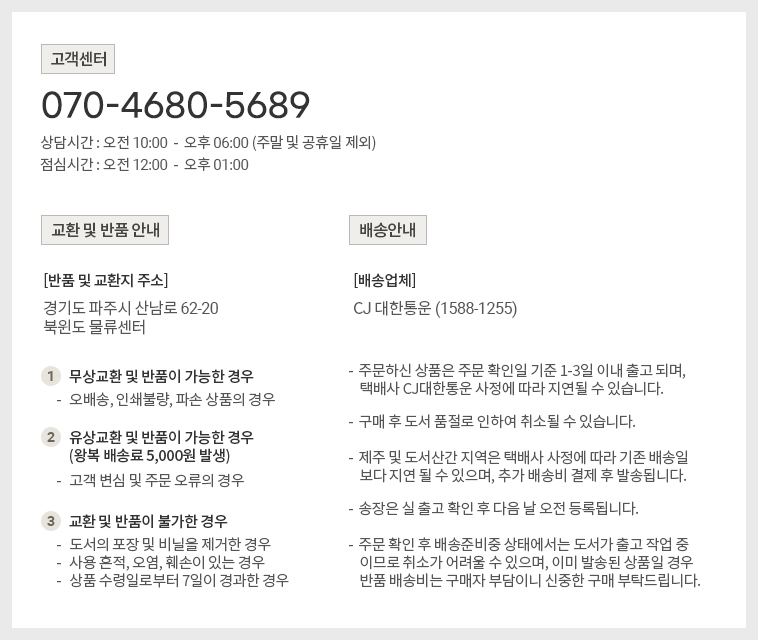

[반품/교환방법]

마이페이지> 주문배송조회 > 반품/교환신청 또는 고객센터 (070-4680-5689)로 문의 바랍니다.

[반품주소]

- 도로명 : (10882) 경기도 파주시 산남로 62-20 (산남동)

- 지번 : (10882) 경기도 파주시 산남동 305-21

[반품/교환가능 기간]

변심반품의 경우 수령 후 14일 이내, 상품의 결함 및 계약내용과 다를 경우 문제점 발견 후 30일 이내

[반품/교환비용]

단순 변심 혹은 구매착오로 인한 반품/교환은 반송료 고객 부담

[반품/교환 불가 사유]

- 소비자의 책임 있는 사유로 상품 등이 손실 또는 훼손된 경우

(단지 확인을 위한 포장 훼손은 제외)

- 소비자의 사용, 포장 개봉에 의해 상품 등의 가치가 현저히 감소한 경우

예) 화장품, 식품, 가전제품(악세서리 포함) 등

- 복제가 가능한 상품 등의 포장을 훼손한 경우

예) 음반/DVD/비디오, 소프트웨어, 만화책, 잡지, 영상 화보집

- 소비자의 요청에 따라 개별적으로 주문 제작되는 상품의 경우 ((1)해외주문도서)

- 디지털 컨텐츠인 eBook, 오디오북 등을 1회 이상 다운로드를 받았을 경우

- 시간의 경과에 의해 재판매가 곤란한 정도로 가치가 현저히 감소한 경우

- 전자상거래 등에서의 소비자보호에 관한 법률이 정하는 소비자 청약철회 제한 내용에 해당되는 경우

* (1) 해외주문도서 : 이용자의 요청에 의한 개인주문상품으로 단순변심 및 착오로 인한 취소/교환/반품 시

‘해외주문 반품/취소 수수료’ 고객 부담 (해외주문 반품/취소 수수료 : ①양서-판매정가의 12%, ②일서-판매정가의 7%를 적용)

[상품 품절]

공급사(출판사) 재고 사정에 의해 품절/지연될 수 있으며, 품절 시 관련 사항에 대해서는 이메일과 문자로 안내드리겠습니다.

[소비자 피해보상, 환불지연에 따른 배상]

- 상품의 불량에 의한 교환, A/S, 환불, 품질보증 및 피해보상 등에 관한 사항은 소비자분쟁해결 기준 (공정거래위원회 고시)에 준하여 처리됩니다.

- 대금 환불 및 환불지연에 따른 배상금 지급 조건, 절차 등은 전자상거래 등에서의 소비자 보호에 관한 법률에 따라 처리함.